딥러닝은 인공신경망을 말하는데, 쉽게 말해서

창고를 질서있게 정리한 후 나중에 물건을 빨리 찾아가는 기술입니다.

이는 인간 두뇌의 정보처리와 같은 맥락이기 때문에 인공신경망이라 말하는 거.

인공신경망의 출발점은 '이다/아니다'를 구분하여

인공신경망이 처리해야할 데이터량을 획기적으로 줄여주는 것인데요.

돼지 눈에는 돼지만 보인다는 것과 같이 관찰자의 세계관을 사용자의 필요에 따라 임의로(컴퓨팅 자원에 따라) 정해주어

분류를 빨리 할 수 있도록 하고, 할 수 없는 것은 무시해버리던지 물음표태그(나중에 처리)를 붙여주는 것이 중요합니다.

인간의 경우에도 사용할 수 있는 두뇌의 데이터 처리량은 한계가 있습니다.

그리고 그 한계에 맞추어 세계관 또한 형성되며, 인지할 수 있는 대상 또한 제한됩니다.

세계관이 커진다고 해서 더 많은 데이터를 처리하는게 아니라

하나를 보게 되면 하나를 볼 수 없게 됩니다.

물론 능력(설정)에 따라 상대적인 대상의 연역적 상부구조를 보느냐 하부구조를 보느냐의 차이는 있습니다.

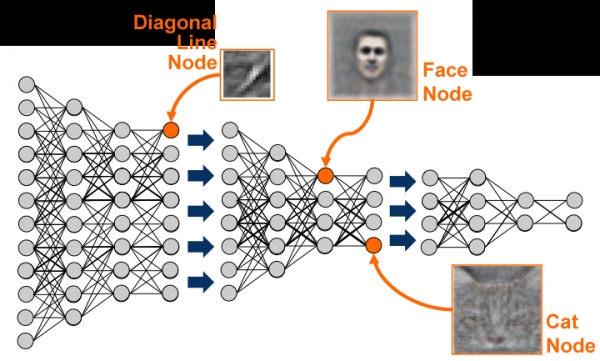

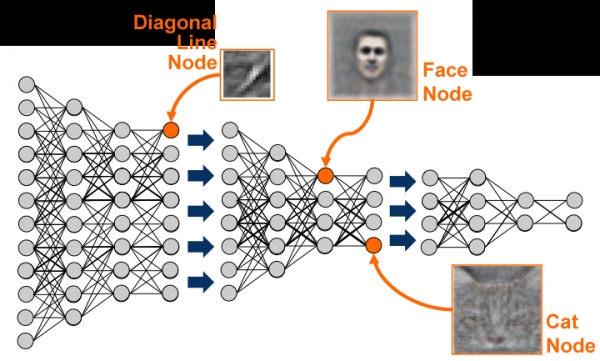

이때 기술의 핵심은 인공지능이 대상의 상부구조를 인지하도록 만들어

하부구조의 데이터는 하향 연역할 수 있게 해야 하는 것입니다.

대부분의 실패는 하부구조의 지나치게 많은 데이터량을 처리하느라고 컴퓨터가 집보다 커져서 생기죠.

게다가 더 큰 문제는 집이 커질 수록 찾는 속도도 느려진다는게 문제.

연역할 수 있게 하면 지나치게 큰 컴퓨팅 자원이 필요하지 않을 수 있습니다.

또한 컴퓨터와 컴퓨터의 사이에는 온라인 허브를 두고 허브에는 인간이 개입할 수 있도록 하여 집단지성을

활용할 수 있도록 하는 것도 중요합니다.

친구끼리 대화를 나누면서 데이터를 정리하는 과정이 컴터에게도 필요하죠. 거기다가 인간의 판단력도 지속적으로 업뎃할 수 있도록 하면 완벽.

관련된 산업은 빅데이터, 음성인식, 사물인터넷, 무인자동차 등입니다. 핫하죠.

인지과학에서 흔히 하는 방법인 것 같은데, 좀 바보같은 방식이죠.

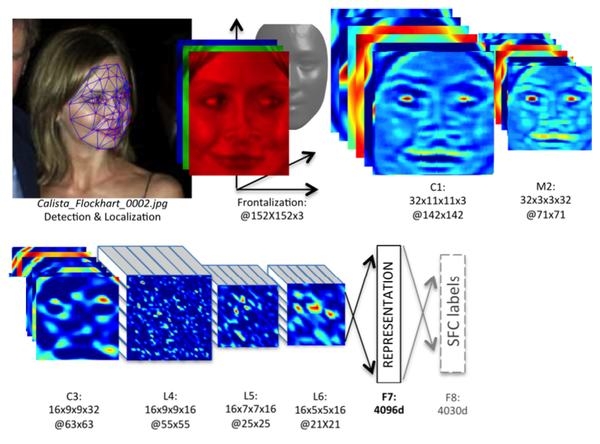

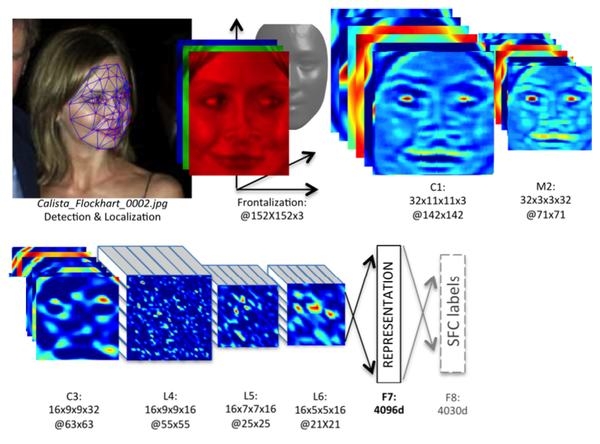

페북에서 사람의 얼굴을 97%로 인지한다고 하는데, 실제로 해보면 좀 뻥인 것 같네요.

사진에서 얼굴의 크기가 좀 작다던지, 뒤통수 혹은 옆모습만 보인다던지 하면 여지없이 틀립니다.

색상구분>덩어리구분>꺾임구분>선구분>점구분의 방식으로 넘어가지 않으면

다른분야에는 적용할 수 없는 일시적인 방식에 그칩니다.

뭔가 순서는 맞는데 노드(연결점)에서 구분하는 언어가 엉뚱하네요.

배태현

배태현

사진을 자세히 보면,

저고리 라인과 어깨선과 손목의 곡선 손의 형태가 예술이오.

문제의 얼굴표정....자세히 보면, 한쪽눈을 좀더 찡그리고, 뭔가 생각하거나 못마땅할때, 혹은 명령을 내릴때 생기는 표정이라고 여겨지고... 이 표정은 제대로 포착하면 카리스마표정인데, 사진은 서서찍었거나 위에서 찍었거나..., 저 표정은 서로 정면이거나 아래에서 위를 올려다볼때 더 위력이 드러나는 표정이라고 여기짐.

그러니까 못생겨서 생긴 표정도 아니고 찡그린 표정도 아니고....의도된 표정이나, 단지 사진의 위치가 문제...

컬러로 재현, 혹은 영화적 표현으로 재현해본다면...바로 알 수 있을듯...