https://news.v.daum.net/v/20220815191001934

한국인이 한국인에게 "야, 이 깜둥아"라고 말해도 혐오표현이 아니나, 한국인이 흑인에게 똑같이 말하면 혐오표현이 됩니다.

단어만으로 그것이 혐오표현인지 아닌지를 판단하는 건 바보짓이라는 거죠. 이런 거 모르는 사람은 없는데, 희안하게 인공지능을 연구하는 사람은 이런 걸 모릅니다.

인간이 쓰는 정도로 언어를 학습하려면 상황, 즉 맥락을 인식해야 하는데, 현재 자연어처리 알고리즘은 그런 게 없습니다. 자연어처리 알고리즘은 단어의 의미를 만들고자 통계적으로 빅데이터를 학습하는데, 그게 문서 안에서만 상대적으로 학습하기 때문. 맥락은 문서 밖에 있는데 말이죠.

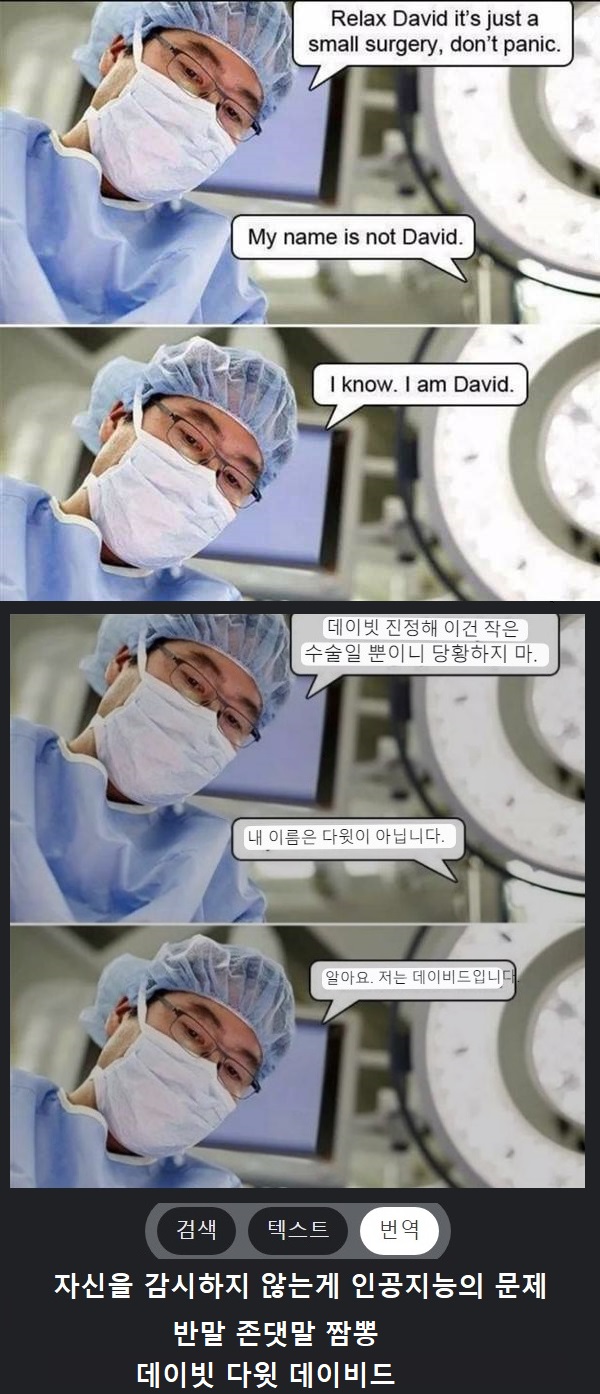

예전에 동렬님이 출석부에 올린 이미지

david를 데이비드, 데이빗, 다윗으로 따로 번역하는 이유는 문서의 맥락없이, 문장의 맥락만으로 단어를 학습하기 때문입니다. 다윗으로 번역한 문장은 성경을 학습한 결과인데, 데이비드와 데이빗이 같은 문서에 나오는 게 자세히 보면 다윗과 데이빗 주변의 단어 분포와 조합이 미묘하게 다른 걸 알 수 있습니다. 여러 문서의 맥락을 섞어서 학습한 결과인데, 이는 제논의 역설과 비슷한 상황이라고도 볼 수 있습니다.

이 단어의 근거는? 저 단어, 그럼 저 단어의 근거는? 이 단어. 즉 현재의 자연어처리 알고리즘이 특정 단어의 주변만 맥락으로 삼을뿐, 더 큰 단위인 문서 주변은 보지 않기 때문에 벌어지는 참사입니다. 그럼 문서 주변은 뭐냐? 출간된 시대, 설정된 독자, 작가의 성향 같은 거죠. 흔히 말하는 메타 정보입니다. 우리는 외부를 내부와 인과관계가 있고 상관관계는 없는 것이라고 합니다. 바로 그 제3의 근거를 가져와야 번역에 일관성이 생깁니다.

상관관계를 근거로 삼는 현재의 머신러닝 번역은 태생부터 불완전합니다. 안 되요, 그건.

Drop here!